Fragment de Radiolaria, sèrie d’ il·lustracions de Ernst Haeckel (1862). Font: Biodiversity Heritage Library | A: Harvard University.

El Big Data és el nou mitjà d’aquest segon decenni de segle. Un nou conjunt de tecnologies computacionals que, com les anteriors, ha canviat la manera en què accedim a la realitat. En un moment en què la web social és el nou laboratori de la producció cultural, les humanitats digitals s’aboquen cap a l’anàlisi de la producció i distribució massiva de productes culturals, per comprometre’s en el disseny i qüestionament dels mitjans que l’han fet possible. D’aquesta manera, adopten un enfocament més centrat a veure com es produeix i distribueix la cultura, que les col·loca davant els reptes d’una nova cultura connectada.

5.264.802 documents de text, 1.735.435 arxius d’àudio, 1.403.785 vídeos i més de dos bilions de pàgines web accessibles a través de la WayBack Machine, constitueixen l’inventari actual de l’Internet Archive. Hi podem sumar les obres de més de 7.500 artistes d’avantguarda, arxivades en forma de vídeos, pdf, arxius sonors, programes de televisió i ràdio en UBUWEB, o les més de 4.346.267 entrades en 241 idiomes, facilitades pels 127.156 usuaris actius que elaboren la Wikipedia i les contínues contribucions dels més de cinc-cents milions d’usuaris del Twitter. Aquests són sols alguns exemples dels nous espais virtuals on s’emmagatzemen i comparteixen coneixements. Arxius digitals, d’accés lliure i contribuïts de manera col·lectiva, wikis i xarxes socials, on conviuen hibridacions i trobades entre diferents mitjans i múltiples continguts. Donen lloc a un entorn complex, on la nostra cultura es mostra com un treball sempre en procés.

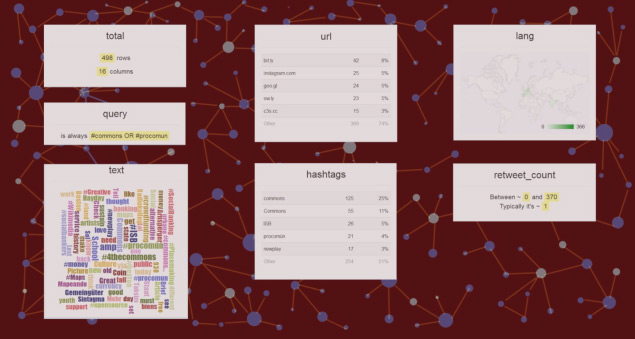

Visualització dades del Twitter. Generat amb Scraperwiki.

En els anys noranta l’ordinador era vist com una «maquina de remediació», és a dir, un mitjà capaç de reproduir els ja existents. Llavors les humanitats digitals es van centrar en la traducció dels documents del nostre patrimoni cultural, tributaris de la cultura de la impremta, al mitjà digital. Un procés de mediació en què els documents van ser reduïts a dades discretes, llegibles i operables per màquines. La computació en humanitats, tal com la descriu Roberto A. Busa en la introducció a A Companion to Digital Humanities, és l’automatització de tota anàlisi possible de l’expressió humana. Aquesta automatització va aportar noves capacitats als documents, que van anar mutant cap a un nou missatge performatiu, que va desplaçar el document escrit com a vehicle predominant del coneixement humà. Alhora, els mateixos processos dedicats a l’anàlisi i reproducció dels textos es van aplicar al desenvolupament d’eines que permetessin accedir a aquests continguts i compartir-los, amb la qual cosa es va produir un canvi de l’arxiu a la plataforma. Ambdues operacions canviaran la manera en què es duu a terme la recerca en les humanitats i definiran el contingut d’unes humanitats digitals 2.0.

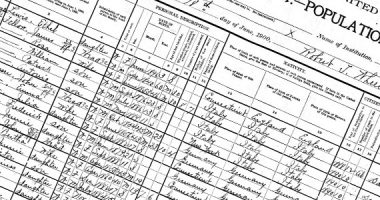

La conversió de documents a codi binari mitjançant l’escanejat o la transcripció, el seu emmagatzematge en bases de dades, aprofitant les capacitats d’aquestes per a la recerca i la recuperació de la informació i l’aplicació de descriptors, etiquetes i metadades, van donar lloc a l’enllaçat i interoperabilitat dels mitjans. Es van crear arxius digitals com el Salem Witch Trial, dirigit per Benjamin Ray a la Universitat de Virgínia el 2002, un repositori de documentació referida a la caça de bruixes de Salem, o The Valley of Shadow construït pel Centre per a la Història Digital a la Universitat de Virgínia, i que documenta les vides de la gent del Comtat d’Augusta a Virgínia i del de Franklin a Pennsilvània, durant el període de la Guerra Civil americana. Es converteixen en espais virtuals navegables, en què s’accedeix a la informació de manera activa, a través d’una estructura que permet enllaçar continguts de diferents bases de dades, emmagatzemades en diferents formats, siguin imatges, textos o arxius sonors. Al mateix temps, la realització d’aquests repositoris, accessibles de manera gairebé ubiqua, suposa un treball col·laboratiu entre professionals de diverses disciplines, des d’historiadors, lingüistes i geògrafs fins a dissenyadors i enginyers informàtics. Aquesta trobada donarà lloc a pràctiques convergents i a la postdisciplinarietat que definirà les humanitats digitals. En aquest treball col·laboratiu en què s’hibriden procediments i formes de representació, apareixen nous formats on contextualitzar la informació, des de l’esquema cronològic fins als mapes geogràfics i les timelines. En aquest sentit, cal esmentar el projecte Digital Roman Forum, dut a terme entre el 1997 i el 2003 pel Cultural Virtual Reality Laboratory (CVRLab) de la Universitat de Califòrnia, Los Angeles (UCLA). Aquest mostra una nova manera d’espacialitzar la informació, creant un model tridimensional del Fòrum romà que funciona com a interfície i que conté diferents càmeres, enfocades als diversos monuments reproduïts. Aquest dispositiu permet comparar la reproducció històrica amb fotografies actuals, al mateix temps que ofereix una relació dels diferents documents que fan referència a aquests espais i que han estat utilitzats per a la realització de la reproducció.

Aquesta capacitat d’accés i enllaç és portada més enllà de l’arxiu per projectes com Perseus o Pelagios, espais en què s’accedeix als continguts i s’hi contribueix de manera col·lectiva i lliure. Aquests fan ús dels estàndards sorgits a les comunitats de pràctica, per relacionar els seus continguts a través de diferents recursos en línia, amb la qual cosa esdevenen, més que no pas repositoris, autèntiques plataformes on produir i compartir coneixement. Així, la llibreria digital Perseus, iniciada el 1985, es basa en l’elaboració d’un programari opensource, que permet un sistema d’operació de dades extensible en un espai de treball en xarxa, a través d’un sistema que funciona a dos nivells, un d’accessible als éssers humans, que permet afegir-hi continguts i descriptors, i un altre que incorpora la capacitat de generar coneixement de les màquines. Aquesta plataforma dóna accés als documents originals, relacionant-los amb múltiples informacions, com ara les seves traduccions i reedicions posteriors, edicions de comentaris, mapes dels espais citats… Tota aquesta informació és exportable en arxius de dades en format xml. El projecte Pelagios, dedicat a la reconstrucció del món antic, elabora un mapa en el qual dades geoespaciales històriques es relacionen amb continguts en altres fonts de recursos en línia. L’accés a un punt del mapa-interfície ens condueix a un conjunt heterogeni format per imatges, traduccions, citacions, bibliografies o altres mapes, tot exportable en diversos formats d’arxius de dades com són xml, Json, atom o klm.

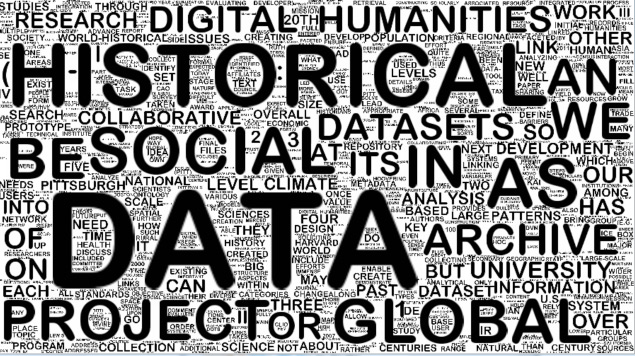

WorldCloud dels abstracts de l’últim congrés de l’ALLC: The European Association for Digital Humanities. Generat amb Processing.

Aquests projectes posen en evidència el gir computacional a les humanitats de què ens parla David M. Berry a The Computational Turn: Thinking about Digital Humanities: Les tècniques computacionals no són solament un instrument al servei dels mètodes tradicionals, sinó que tenen un efecte en tots els aspectes de les disciplines. No solament introduint nous mètodes adreçats a la identificació de nous patrons en les dades, que van més enllà de la narrativa i comprensió tradicionals, sinó permetent la modularització i recombinació de les disciplines, més enllà de l’ambient acadèmic tradicional. L’aplicació de l’automatització lligada a la digitalització no solament ofereix noves capacitats d’anàlisi dels documents textuals, sinó que també dóna lloc a noves capacitats de recombinació i producció de coneixement, així com al sorgiment de noves plataformes, esferes públiques, on la distribució de la informació ja no es pot pensar de manera independent a la seva producció.

Aquest gir computacional és descrit a The Digital Humanities Manifesto 2.0, redactat el 2009 per Jeffrey Schnapp i Todd Presner, com la conversió del primer impuls quantitatiu de les humanitats digitals a un de qualitatiu, interpretatiu, emotiu i generatiu. Aquest està més implicat en la complexitat i l’especificitat del mitjà, el seu context històric, la seva crítica i interpretació. Una reformulació d’objectius en què els mitjans digitals són considerats profundament generatius, i en què s’analitzen les maneres natives digitals del discurs i la investigació, sorgides a les esferes públiques emergents, com ara els wikis, la blogosfera, i les llibreries digitals. Això permet comprometre’s en el disseny de les eines, el programari, que ha donat lloc a aquesta nova forma de producció de coneixement, així com al manteniment de les xarxes en què es produeix aquesta cultura. Està caracteritzada per ser opensource, adreçada a múltiples propòsits i distribuïda en múltiples canals. Sorgeix de la col·laboració d’una manera processual i en què el coneixement assumeix múltiples formes, des de la composició d’imatges fins a l’orquestració musical, la crítica de textos i la fabricació d’objectes, en una convergència entre l’art, la ciència i les humanitats.

La capacitat generativa dels nous mitjans i la seva capacitat de comunicació han donat lloc a la distribució i producció massiva de productes culturals. En aquesta època que Manovich anomena del more media, és el moment de pensar la cultura en termes de dades. Dades no solament procedents de la tradició emmagatzemada en els arxius digitals, sinó també produïdes de manera digital a partir de les metadades, els tags, la visió computeritzada, les empremtes digitals, les estadístiques i els metacanals –blogs i comentaris en xarxes socials que fan referència a altres continguts–, dades que poden ser minades i visualitzades. Citant l’última obra d’aquest autor, «Sofware takes command». Si l’anàlisi, el minat i la visualització de dades han estat adoptats pels científics, negocis i governs com una nova manera de generar coneixement, podem aplicar la mateixa comprensió a la cultura. D’aquesta manera, els mètodes aplicats a la computació social –el traçat i l’anàlisi de dades produïdes en les nostres interaccions amb l’entorn, per a una major eficiència en l’oferta de productes de consum o la planificació de les nostres ciutats– podrien ser utilitzats per trobar nous patrons en la producció cultural. Aquests permetrien no solament desenvolupar noves categories, sinó també traçar i seguir com i amb quines eines es produeix aquesta cultura. L’analítica cultural aplicada en el Software Studies des del 2007 és una proposta en aquest sentit. Consisteix en el desenvolupament d’eines de visualització que permetin analitzar conjunts massius de productes culturals, especialment imatges. D’aquesta manera, a partir del programari ImagePlot i de pantalles de gran resolució, es duen a terme projectes en què es parametritzen grans conjunts d’imatges. Aquestes permeten descobrir nous patrons que qüestionen les categories de l’anàlisi cultural. Entre aquests projectes, Phototrails permet visualitzar patrons visuals i estructures dinàmiques en fotos generades i compartides pels usuaris de diferents xarxes socials.

En una altra línia, hi ha projectes que analitzen les empremtes digitals per seguir la producció i distribució del coneixement. És el cas del History Flow de Martin Wittenberg i Fernanda B. Viégas –desenvolupat en el Collaborative User Experience Reserach Group d’IBM–, que construeix un histograma de les aportacions que conformen la Wikipedia.

L’ús del Big Data, aplicat a la producció cultural, ens permet representar de manera contínua i espacial com es conforma la nostra cultura visual i com es produeix el coneixement, posant les humanitats digitals davant els nous reptes d’una cultura de dades generada en xarxa. Reptes que vinculen l’anàlisi del programari amb qüestions epistemològiques, pedagògiques i polítiques. Aquests plantegen diferents qüestions, entre elles: la manera en què s’obtenen les dades; quines entitats parametritzem, a risc de deixar fora de la representació parts de la realitat; com assignem valor a aquestes dades, tenint en compte que això tindrà un impacte directe en com aquestes podran ser visualitzades, així com que la visualització té una gran força retòrica, en virtut de les seves capacitats gràfiques, per la qual cosa pot distorsionar aquestes dades; com s’estructura la informació en els entorns digitals, ja que aquesta estructuració suposa un model de coneixement i una ideologia; com mantenim estàndards que permetin la interoperabilitat de les dades, i com afrontem la tasca política de fer que aquestes dades siguin d’accés lliure; quines noves formes de narrativa no lineal, multimèdia i col·laborativa es poden desenvolupar a partir d’aquestes dades; la qüestió pedagògica de com instruir en la comprensió del codi digital i del mitjà algorítmic humanistes educats en la divisió entre cultura i ciència, i finalment, com apropar les institucions culturals al laboratori, fent que es comprometin, ja no en la preservació, sinó en la participació i el manteniment de les xarxes que fan possible la producció del coneixement.

Deixa un comentari